به نام خدا

آزمونهای آماری

استنتاج آماری

کلیت روشهای مربوط به فرضیه بر اساس گامهای زیر است:

شش بخش آزمودن یک فرضیه به شرح زیر است:

کلیت روشهای مربوط به فرضیه بر اساس گامهای زیر است:

- در نظر گرفتن یک فرض اولیه.

- جمع آوری شواهد(دادهها)

- با توجه به دادههای جمعآوری شده، تصمیم میگیریم که فرض اولیه را رد کنیم یا خیر.

شش بخش آزمودن یک فرضیه به شرح زیر است:

- داشتن دو فرضیه که در تقابل یکدیگر هستند.

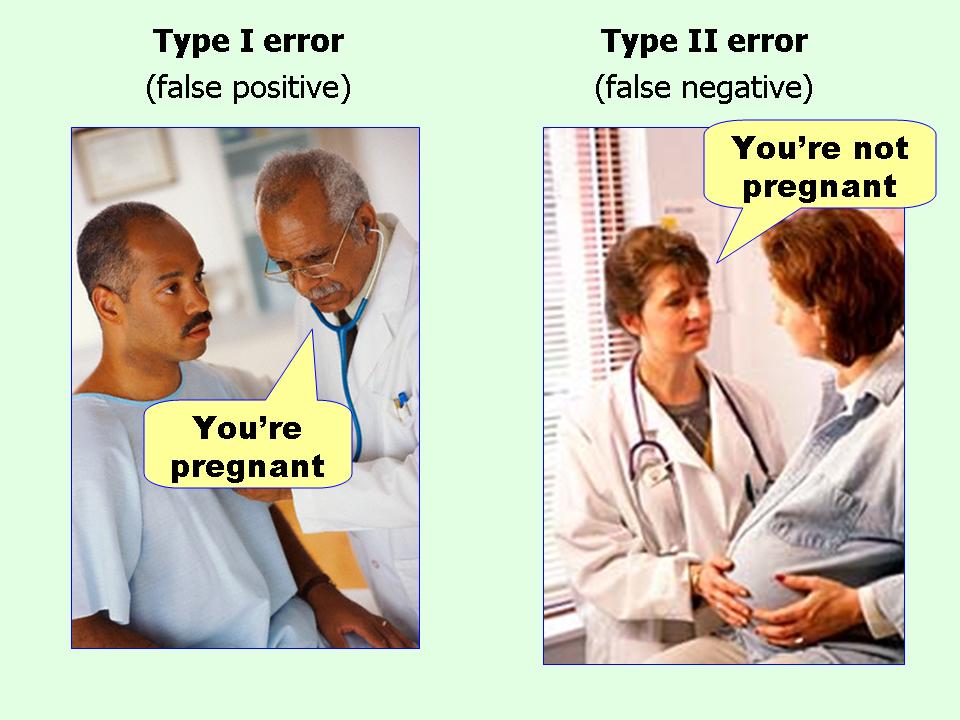

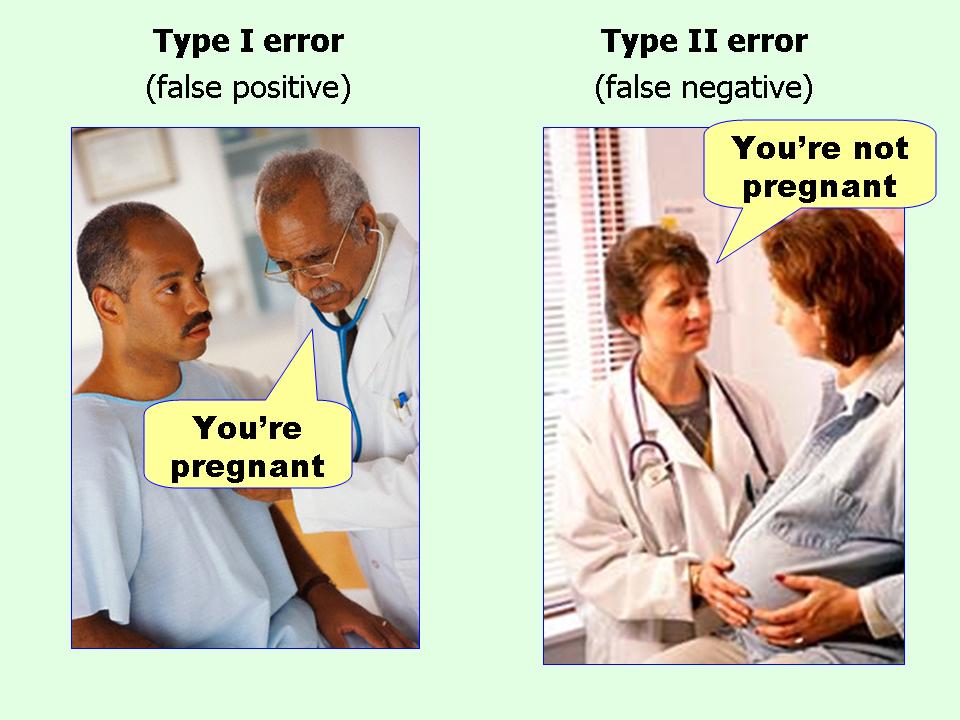

- معین کردن سطح اهمیت یا خطای نوع اول(که بعدا مشخص میشود کدام خطا است) که معمولا آن را α مینامیم.

- محاسبهی یک آمارهی متناظر با فرصیه.

- محاسبهی احتمال وقوع(p-value) و تعیین مرز برای بازههای مردود بودن فرضیه.

- در نظر گرفتن یک آزمون صحت یا عدم صحت برای فرض صفر (همان فرض اولیهی مد نظرمان)

- بیان نتیجهگیری کلی حاصل از تست

آزمون فرضیه

عناصر اصلی آزمون فرضیه عبارتاند از:

عناصر اصلی آزمون فرضیه عبارتاند از:

- فرض صفر(H0) و فرض مقابل آن(H1): فرض صفر در واقع همان فرضیهای است که میخواهیم آن را مورد بررسی قرار دهیم. حالات مختلف فرض مقابل را در قسمت بعد توضیح خواهیم داد

- آمارهی آزمون: آن آمارهی خاصی از دادهها که بر اساس آن تصمیم میگیریم تا H0 (فرض صفر) را رد کنیم و یا قبول کنیم.

- مقادیر بحرانی: مقادیری از آمارهی آزمون که مرز بین ناحیهی مردودی فرضیه و ناحیهی قابل پذیرش بودن فرضیه را مشخص میکند.

- ناحیهی مردودی: مجموعه مقادیری از آمارهی آزمون که به ازای آنها نتیجه میگیریم که فرضیه مردود بوده است.

- ناحیهی پذیرش: مجموعه مقادیری از آمارهی آزمون که به ازای آنها نتیجه میگیریم که فرضیه با دقت مورد نظر مردود نبوده است.

- P-value یا probability value: احتمال اینکه آمارهی آزمون به شرط صحت فرض صفر، حداقل به شدت مقدار مشاهده شده باشد.

| Decision | H0 is true | H0 is false |

|---|---|---|

| Don't Reject H0 | OK | β = probability of type II error |

| Reject H0 | α = probability of type I error | OK |

فرض صفر و انواع فرض مقابل آن

همان طور که قبلا گفتیم، فرض صفر در واقع همان فرضیهای است که میخواهیم آن را مورد بررسی قرار دهیم. مثلا مجموعهای به اندازهی ۱۰۰ نمونه از اطلاعات قد مردان کشور گینه بیسائو به ما داده شده است و میانگین قدشان 174 سانتیمتر است. فرض صفر ما میتواند این باشد که میانگین قد کل مردان این کشور 170 سانتیمتر است. یا مثلا مجموعه نمرات ریاضی ۲۵ دانشآموز پسر و ۳۰ دانشآموز دختر به ما داده شده است و میانگین پسرها و دخترها به ترتیب 14.5 و 15 است. فرض صفر را میتوانیم تساوی میانگین نمرهی پسرها و دخترها در نظر بگیریم.

فرض مقابل فرض صفر را به سه شکل میتوانیم در نظر بگیریم:

همان طور که قبلا گفتیم، فرض صفر در واقع همان فرضیهای است که میخواهیم آن را مورد بررسی قرار دهیم. مثلا مجموعهای به اندازهی ۱۰۰ نمونه از اطلاعات قد مردان کشور گینه بیسائو به ما داده شده است و میانگین قدشان 174 سانتیمتر است. فرض صفر ما میتواند این باشد که میانگین قد کل مردان این کشور 170 سانتیمتر است. یا مثلا مجموعه نمرات ریاضی ۲۵ دانشآموز پسر و ۳۰ دانشآموز دختر به ما داده شده است و میانگین پسرها و دخترها به ترتیب 14.5 و 15 است. فرض صفر را میتوانیم تساوی میانگین نمرهی پسرها و دخترها در نظر بگیریم.

فرض مقابل فرض صفر را به سه شکل میتوانیم در نظر بگیریم:

-

فرض مقابل این باشد که پارامتر جامعهی آماری با مقدار معینی نامساوی است. در این حالت به آزمون، آزمون دوطرفه گفته میشود. H1: p ≠ p0 or μ ≠ μ0

مثلا در مورد همان نمرهی ریاضی فرض صفر، تساوی میانگین دو گروه، و فرض مقابل آن عدم تساوی میانگین است. -

فرض مقابل این باشد که پارامتر جامعهی آماری از مقدار معینی بیشتر است. در این حالت به آزمون، آزمون یکطرفه از راست گفته میشود. H1: p > p0 or μ > μ0

مثلا میخواهیم بررسی کنیم که یک پیتزافروشی آیا به طور میانگین ظرف ۳۰ دقیقه غذا را آماده میکند؟(فرض صفر این میشود که میانگین مدت زمان لازم برای آماده شدن پیتزا، ۳۰ دقیقه است.) اکنون باید ببینیم فرض مقابل را چه انتخاب کنیم. منطقی نیست که فرض مقابل را عدم تساوی میانگین با ۳۰ دقیقه باشد بلکه در این حالت بهتر است فرض مقابل را «بیشتر بودن میانگین زمان مورد نیاز از عدد ۳۰» بگیریم. - فرض مقابل این باشد که پارامتر جامعهی آماری از مقدار معینی کمتر است. در این حالت به آزمون، آزمون یکطرفه از چپ گفته میشود. H1: p < p0 or μ < μ0

توضیح در مورد $p-value$

همینجا برای همیشه از گینه بیسائوی لوس و بیمزه خداحافظی میکنیم و مثال بهتری خواهیم زد.

سؤالی که پیش میآید این است که چه $p-value$ای مناسب است؟به یاد آورید که $\alpha$ به معنای درجهی اهمیت است و قبل از انجام آزمون فرض مقدار آن را به دلخواه تعیین میکنیم. به صورت کلی $\alpha$ را ۵، ۱ یا ۰.۱ انتخاب میکنند.

دقت کنید که $p-value$ احتمال است بنابراین همواره مقدار بین صفر تا ۱ میگیرد.

به صورت زیر میتوان دقیقتر مقادیر $p-value$ را تفسیر کرد:

- گینه بیسائو یا جمهوری دموکراتیک کنگو؟ مساله این است!

همینجا برای همیشه از گینه بیسائوی لوس و بیمزه خداحافظی میکنیم و مثال بهتری خواهیم زد.

- پرتاب سکه

سؤالی که پیش میآید این است که چه $p-value$ای مناسب است؟به یاد آورید که $\alpha$ به معنای درجهی اهمیت است و قبل از انجام آزمون فرض مقدار آن را به دلخواه تعیین میکنیم. به صورت کلی $\alpha$ را ۵، ۱ یا ۰.۱ انتخاب میکنند.

دقت کنید که $p-value$ احتمال است بنابراین همواره مقدار بین صفر تا ۱ میگیرد.

به صورت زیر میتوان دقیقتر مقادیر $p-value$ را تفسیر کرد:

- $p-value$ بسیار کم (خیلی کمتر از $\alpha$) مدرکی قوی علیه صحت فرض صفر است. در این صورت فرض صفر را رد میکنیم.

- $p-value$ بسیار بالا (خیلی بیشتر از $\alpha$) مدرکی ضعیف علیه صحت فرض صفر است. در این صورت موفق به رد کردن فرض صفر نمیشویم.

- $p-value$ای که بسیار نزدیک به $\alpha$ باشد را میتوان به هر دو صورت تفسیر کرد.

آزمون میانگین جامعهی آماری و استفاده از توزیع t

فرض کنید که مدت زمان لازم برای آماده شدن پیتزا در یک رستوران را در طول یک روز یادداشت کردهاید. میانگین زمانهایی را که یادداشت کردهاید محاسبه میکنید و میبینید که برابر با ۴۰ شده است.

اکنون با خود فکر میکنید که آیا ممکن است میانگین زمان آماده شدن یک پیتزا ۳۰ دقیقه باشد؟ نکند من روز بدی را برای یادداشت کردن زمان لازم انتخاب کردهام و کلا پیتزاها فقط همین یک روز ۱۰ دقیقه دیرتر آماده شدهاند؟ به عبارتی این سوال پیش میآید که شاید هر اختلافی بین میانگین نمونههای داده با سایر زمانهای ممکن برای میانگین زمان مورد نیاز آماده شدن پیتزا، صرفا به خاطر واریانس نمونه برداری باشد؟

به طور کلی فرض صفر را این طور در نظر میگیریم که «هر اختلاف مشهودی، تصادفی و صرفا شانسی رخ داده است» در حالی که فرض مقابل آن، ردکنندهی این تصور است.

اگر واریانس جامعه برای ما معلوم باشد، بنابراین به راحتی میتوانیم به این سوال پاسخ بدهیم.(در این صورت نیازی به توزیع t نیست و آمارهای که میسازیم، توزیع نرمال دارد.) اما در عمل واریانس جامعه برای ما معلوم نیست و به جای واریانس جامعه، صرفا از روی نمونهها میتوانیم $s^2$ را محاسبه کنیم که تخمینی از واریانس جامعه است: $$\overline{x} = \frac{1}{n}\sum_{i = 1}^n{x_i} \quad \quad s^2 = \frac{\sum_{i = 1}^n(x - \overline{x})^2}{n - 1} $$

مقدار $\overline{x}$ میانگین، $s^2$ واریانس و $n$ اندازهی نمونهی آماری است.

اکنون آمارهی مورد نظر خودمان را میسازیم: $$t = \frac{\overline{x} - \mu_0}{\sqrt{s^2/n}}$$ این آماره، توزیع t دارد. توزیع t در واقع شبیه توزیع نرمال است و هر چقدر که پارامتر آن بزرگتر شود، به توزیع نرمال نزدیکتر میشود. پارامتر این توزیع در اینجا برابر با اندازهی نمونهی آماری منهای ۱ است. یعنی هر چقدر اندازهی نمونه بزرگتر باشد، توزیع این آماره به نرمال نزدیکتر میشود.(چرا چنین انتظاری هم باید میداشتیم؟)

هر چقدر واریانس نمونه بزرگتر باشد، یعنی در دادهها پراکندگی بیشتری داشتهایم و در نتیجه اختلاف بین میانگین دادهها و فرض صفر قابل تحملتر.

برای استفاده از این آزمون، متغیر تصادفی تحت آزمایش باید شرایط زیر را دارا باشد:

به طور کلی برای آزمون میانگین با استفاده از آزمون توزیع t مراحل زیر را باید طی کرد:

فرض کنید که مدت زمان لازم برای آماده شدن پیتزا در یک رستوران را در طول یک روز یادداشت کردهاید. میانگین زمانهایی را که یادداشت کردهاید محاسبه میکنید و میبینید که برابر با ۴۰ شده است.

اکنون با خود فکر میکنید که آیا ممکن است میانگین زمان آماده شدن یک پیتزا ۳۰ دقیقه باشد؟ نکند من روز بدی را برای یادداشت کردن زمان لازم انتخاب کردهام و کلا پیتزاها فقط همین یک روز ۱۰ دقیقه دیرتر آماده شدهاند؟ به عبارتی این سوال پیش میآید که شاید هر اختلافی بین میانگین نمونههای داده با سایر زمانهای ممکن برای میانگین زمان مورد نیاز آماده شدن پیتزا، صرفا به خاطر واریانس نمونه برداری باشد؟

به طور کلی فرض صفر را این طور در نظر میگیریم که «هر اختلاف مشهودی، تصادفی و صرفا شانسی رخ داده است» در حالی که فرض مقابل آن، ردکنندهی این تصور است.

اگر واریانس جامعه برای ما معلوم باشد، بنابراین به راحتی میتوانیم به این سوال پاسخ بدهیم.(در این صورت نیازی به توزیع t نیست و آمارهای که میسازیم، توزیع نرمال دارد.) اما در عمل واریانس جامعه برای ما معلوم نیست و به جای واریانس جامعه، صرفا از روی نمونهها میتوانیم $s^2$ را محاسبه کنیم که تخمینی از واریانس جامعه است: $$\overline{x} = \frac{1}{n}\sum_{i = 1}^n{x_i} \quad \quad s^2 = \frac{\sum_{i = 1}^n(x - \overline{x})^2}{n - 1} $$

مقدار $\overline{x}$ میانگین، $s^2$ واریانس و $n$ اندازهی نمونهی آماری است.

اکنون آمارهی مورد نظر خودمان را میسازیم: $$t = \frac{\overline{x} - \mu_0}{\sqrt{s^2/n}}$$ این آماره، توزیع t دارد. توزیع t در واقع شبیه توزیع نرمال است و هر چقدر که پارامتر آن بزرگتر شود، به توزیع نرمال نزدیکتر میشود. پارامتر این توزیع در اینجا برابر با اندازهی نمونهی آماری منهای ۱ است. یعنی هر چقدر اندازهی نمونه بزرگتر باشد، توزیع این آماره به نرمال نزدیکتر میشود.(چرا چنین انتظاری هم باید میداشتیم؟)

هر چقدر واریانس نمونه بزرگتر باشد، یعنی در دادهها پراکندگی بیشتری داشتهایم و در نتیجه اختلاف بین میانگین دادهها و فرض صفر قابل تحملتر.

برای استفاده از این آزمون، متغیر تصادفی تحت آزمایش باید شرایط زیر را دارا باشد:

- باید پیوسته باشد.

- باید توزیع تقریبا نرمال داشته باشد.

- نباید شامل دادههای پرت باشد.

به طور کلی برای آزمون میانگین با استفاده از آزمون توزیع t مراحل زیر را باید طی کرد:

- یک فرض اولیه برای آزمودن در نظر میگیریم.

- سطح اطمینان (α) را مشخص میکنیم. یعنی میخواهیم خطای قابل قبول نوع اول را مشخص کنیم.

-

مقادیر آمارههای آزمون را محاسبه میکنیم:

$$t = \frac{\overline{x} - \mu_0}{\sqrt{s^2/n}}$$

و در مثال بررسی سالم بودن یک سکه که شکست یا پیروزی داریم، به شکل زیر محاسبه میکنیم:

$$t = \frac{\overline{p}-p_{0}}{\sqrt{\frac{p_{0} (1-p_{0})}{n}}}$$

که در آن $\mu_0$ و $p_0$ همان مقادیر مربوط به فرض صفر هستند. - مقادیر بحرانی مناسب را برای آزمون پیدا میکنیم.

- بررسی میکنیم که آیا مقدار محاسبه شدهی آماره در ناحیهی مردودی قرار گرفته است یا خیر.

- نتیجهگیری را بیان میکنیم.

آزمون مقایسهی میانگین دو جامعهی آماری

برای آزمون مقایسهی میانگین دو جامعهی آماری، از فرمول زیر استفاده میکنیم: $$t=\frac{{\overline{x}}_1-{\overline{x}}_2}{s_p \sqrt{\frac{1}{n_1}+\frac{1}{n_2}}}$$

که در آن $s_p$ از عبارت زیر محاسبه میشود:$$s_p =\sqrt{\frac{(n_1-1)s_1^2+(n_2-1)s_2^2}{n_1+n_2-2}}$$

کدهای زیر مثال از حالات مختلف این تست به ازای دو مجموعهی دادهی فرضی x و y هستند:

برای آزمون مقایسهی میانگین دو جامعهی آماری، از فرمول زیر استفاده میکنیم: $$t=\frac{{\overline{x}}_1-{\overline{x}}_2}{s_p \sqrt{\frac{1}{n_1}+\frac{1}{n_2}}}$$

که در آن $s_p$ از عبارت زیر محاسبه میشود:$$s_p =\sqrt{\frac{(n_1-1)s_1^2+(n_2-1)s_2^2}{n_1+n_2-2}}$$

کدهای زیر مثال از حالات مختلف این تست به ازای دو مجموعهی دادهی فرضی x و y هستند:

In [ ]:

# Using the x; y interface:

t.test(x, y, alt = "two:sided") # H1: mean(x) != mean(y) (default)

t.test(x, y, alt = "less") # H1: mean(x) < mean(y)

t.test(x, y, alt = "greater") # H1: mean(x) > mean(y)

# Using the formula interface:

t.test(y ~ g, data = d, alt = "two:sided") # H1: level1 mean = level2 mean

t.test(y ~ g, data = d, alt = "less") # H1: level1 mean < level2 mean

t.test(y ~ g, data = d, alt = "greater") # H1: level1 mean > level2 mean

آزمون خوبی برازیدن یک تابع توزیع بر یک جامعهی آماری

فرض کنید که تعدادی نمونهی داده در اختیار داریم.

فرض کنید که تعدادی نمونهی داده در اختیار داریم.

- ابتدا فرض میکنیم که رفتار جامعهی نمونه از فلان توزیع خاص پیروی میکند.

- فرض مقابل این است که این جامعه چنین توزیعی نداشته باشد.

- از یک آزمون مثل آزمون خوبی برازیدن مربع کای استفاده میکنیم.(Chi-square Goodness-of-fit)

- آمارهی مورد نظر را باید با بازهبندی برای متغیرهای پیوسته محاسبه کنیم. مثلا در مورد آزمون مربع کای، دادهها را به kبازه، بازهبندی میکنیم و درصد تکرار هر بازه را در جامعهی نمونه محاسبه میکنیم. سپس آمارهی زیر را محاسبه میکنیم. $$\chi^{2} = \sum_{i=1}^{k}(O_{i} - E_{i})^{2}/E_{i}$$

که در آن E مقدار احتمال آن بازه در تابع توزیع فرضیه و O احتمال وقوعی است که برای بازه بر حسب فراوانی آن بازه در جامعهی آماری محاسبه کردهایم. بدین ترتیب آمارهی این تست محاسبه میشود.

این آزمون در واقع غیرپارامتری بود. در ادامه به سایر آزمونهای غیرپارامتری میپردازیم.

آزمونهای آماری در R

در این قسمت به مفهوم و کاربرد آزمونهای آماری میپردازیم و طریقه استفاده از آنان را در R خواهیم دید.

به طور کلی آزمونهای آماری به دو بخش پارامتری و غیر پارامتری تقسیم میشوند.

در آزمونهای پارامتری فرض ما این است که اطلاعاتی درمورد پارامترهای توزیع جامعه داریم.

در این قسمت به مفهوم و کاربرد آزمونهای آماری میپردازیم و طریقه استفاده از آنان را در R خواهیم دید.

به طور کلی آزمونهای آماری به دو بخش پارامتری و غیر پارامتری تقسیم میشوند.

در آزمونهای پارامتری فرض ما این است که اطلاعاتی درمورد پارامترهای توزیع جامعه داریم.

- t-test در مورد آزمون t در بالا به طور کامل توضیح داده شد. این آزمون یک آزمون پارامتری برای مقایسه میانگین یک جامعه و یا دو جامعه با یکدیگر استفاده میشود.

In [ ]:

t.test()

- ANOVA این آزمون شکل شکل کلیتر از آزمون t برای مقایسه میانگین بیش از 2 گروه میباشد.

این آزمون به بررسی اینکه آیا میانگین یکی از گروهها از نظر آماری نسبت به بقیه گروهها معنادار است یا خیر، میپردازد. در ANOVA فرض صفر برابر بودن میانگین گروهها میباشد و فرض دیگر برابر نبودن این میانگین هاست.

آزمون ANOVA نیز همانند t-test هم برای گروههای مستقل و هم برای وابسته (در هنگامی که چند مشاهده از یک متغیر داریم) میتوان استفاده کرد.

In [ ]:

anova()

- Chi-Square Goodness of Fit Test

یک آزمون غیر پارامتری برای هنگامی که یک متغیر دستهای داریم و میخواهیم بررسی کنیم آیا نمونه ما از یک توزیع می باشند یا خیر.

مثال:

ما میزان فروش شعب مختلف یک فروشگاه را داریم و میخواهیم ببینیم عملکرد این شعب یکسان میباشد یا خیر. طبیعتا اگر عملکرد آنها یکسان باشد از یک توزیع میآیند. پس با انجام آزمون Goodness of fit این موضوع را میتوان بررسی کرد.

In [ ]:

chisq.test()

- Wilcoxon–Mann–Whitney U Test

آزمون غیر پارامتری برای مقایسه میانگین دو جامعه میباشد. این آزمون جایگزین t-test در هنگامی است که فرض نرمال بودن در جامعه را نداریم.

In [ ]:

wilcox.test()

- Kruskal-Wallis H Test

یکی دیگر از آزمونهای غیر پارامتری میباشد که برای تشخیص تفاوت معنادار آماری بین میانگین دو یا تعدادی بیشتر گروه مستقل به کار میرود.

این آزمون گسترش پیدا کرده آزمون Mann-Whitney میباشد و شکل غیر پارامتری آزمون ANOVA.

فرض صفر در این آزمون عدم وجود تفاوت در بین میانگین گروهها میباشد.

In [ ]:

kruskal.test()

- Spearman Correlation Test

آزمونی غیرپارامتری برای بررسی قدرت همبستگی بین دو متغیر میباشد.

In [ ]:

cor.test(method="spearman")